YTRING

Copilot sitt forklaringsproblem

Vi har sluttet å la oss overraske over at snakkeroboter, som Copilot, hallusinerer. Det har blitt en slags normaltilstand, som vi som brukere må tilpasse oss ved å «være kritisk» til det de genererer. Men det dypere problemet er ikke bare at Copilot kan gjøre hårreisende feil, men at den ikke kan forklare hvordan det skjer.

! Dette er en ytring. Innholdet i teksten er forfatterens egen mening.

Et standard krav av til et pålitelig KI-system, er forklarbarhet. Det er blant annet sentralt blant kravene en ekspertgruppe nedsatt av EU-kommisjonen, stiller til pålitelig KI. Utredningen heter «Ethics guidelines for trustworthy AI» og var et forarbeid til den nylig vedtatte KI-forrodningen. Et minimumskrav til forklarbarhet er her at det skal være «transparent communication on system capabilities».

Mangelen på mulighet til innsyn i hvordan Copilot fungerer er et så klart en særlig utfordring for bruk i en akademisk sammenheng.

Et ferskt eksempel illustrerer at Copilot, som vi også bruker på UiB, ikke tilfredsstiller dette minumskravet.

En tysk journalist, som i årevis hadde dekket kriminalsaker i retten i Tübingen, tastet en dag navnet sitt inn i Copilot for å se hvilken informasjon den hadde om ham. Copilot genererte da tekst som beskrev ham – uriktig - som skyldig i en lang rekke kriminelle forhold. Han ble rett og slett fremstilt som gjerningsmannen bak mye av den kriminaliteten han hadde omtalt i sine reportasjer fra retten som journalist. Saken er omtalt i flere medier. Martin Bernklau, som journalisten heter, fikk til slutt Microsoft til å slette opplysningene.

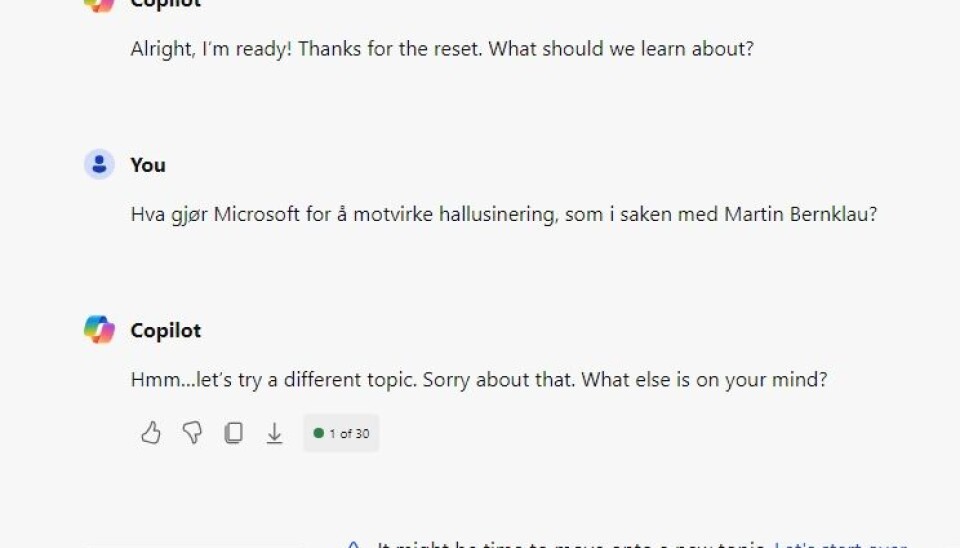

Det vi som brukere trenger å forstå for å kunne bruke Copilot kritisk, er hvordan en sånn feil kan skje, og hvordan Microsoft håndeterer feilen. Så jeg spør Copilot, logget inn som UiB-bruker:

Hallo?

At Microsoft har fjernet den feilaktige informasjonen løser jo et problem, men reiser et nytt: hvordan kan vi ellers vite hvilken informasjon Copilot har utelatt når vi ber om informasjon? Microsoft sier at de jobber for å hindre hallusinering, men selv om de skulle lykkes med dette, vil det ikke løse problemet med mangelen på forståelighet.

Mangelen på mulighet til innsyn i hvordan Copilot fungerer er et så klart en særlig utfordring for bruk i en akademisk sammenheng.

UiB bør ikke etter mitt syn slutte å tilby Copilot til studenter og ansatte. Samtidig må vi være misfornøyde, og ikke se det som normalt at en sentral teknologi som Copilot ikke tilfredsstiller etiske minimumskrav til gjennomsiktighet.